Dieser Leitfaden zeigt, wie Administratoren in Deutschland ein robustes Speichersystem mit ZFS auf Ubuntu einrichten und betreiben. Sie erhalten klare Schritte für Installation, erstes pool-Design und sichere Snapshot-Workflows.

Wir erklären Kernvorteile wie Copy-on-Write, 256-bit Checksummen und Selbstheilung durch Scrubs. So verstehen Sie, wie Integrität und performance Ihrer data erhalten bleiben.

Praxisbeispiele zeigen die richtige Benennung von snapshot-Objekten, das Auflisten und Basis-Commands. Beispiel: sudo apt install zfsutils-linux und zfs snapshot pool1/fs@snap1.

Sie lernen automatisierte Intervalle, Retention-Strategien und Mail-Alerts für Fehler und Kapazitätswarnungen. Kurze Shell-Beispiele helfen beim schnellen Einstieg, etwa zfs list -t snapshot oder zfs scrub -s pool1.

Am Ende dieses Abschnitts wissen Sie, wie Backup-Pfade mit zfs send/receive gestartet werden und wie Scrub-Zeitpläne Ausfallzeiten minimieren.

Warum ZFS auf Ubuntu Server: Integrität, COW-Transaktionen und selbstheilende Storage

Für stabile Speicherung ist eine Kombination aus Checksummen, Copy-on-Write-Transaktionen und effizientem Caching entscheidend. Das Dateisystem prüft jeden Block mit 256-bit-Checksummen und erkennt so stille Korruption zuverlässig.

Write-Operationen bleiben atomar dank COW. Dadurch ist ein snapshot-tauglicher Zustand jederzeit konsistent. Klassische fsck-Läufe entfallen, da inkonsistente Partitionszustände vermieden werden.

Das pooled storage Modell trennt physische Medien vom file system. Administratoren erweitern Pools flexibel ohne komplexe Partitionen. Der 128-bit-Adressraum erlaubt Wachstum bis in Exa-/Zetta-bytes.

Hintergrund-Scrubs lesen Daten, vergleichen Checksummen und reparieren beschädigte Blöcke aus Redundanz. So sinkt das Ausfallrisiko, bevor Fehler kritisch werden.

Performance profitiert von ARC im RAM und optionaler L2ARC auf schnellen SSDs. Ein separates SLOG (ZIL) beschleunigt synchrone Writes etwa bei Datenbanken und VMs. Inline-Kompression (empfohlen: LZ4) reduziert I/O und kann Durchsatz erhöhen.

Voraussetzungen und Installation auf Ubuntu

Bevor Sie ein pool anlegen, prüfen Sie die Hardware- und Kernel-Voraussetzungen. Eine saubere Vorbereitung reduziert späteren Aufwand und schützt Datenintegrität.

Hardware-Empfehlungen und Kernel-Support

Planen Sie eine Multi‑Core CPU und mindestens 4 GB RAM; 8 GB sind empfehlenswert. Für große pools rechnet man etwa 1 GB RAM pro TB. ECC-RAM erhöht die Zuverlässigkeit in Enterprise-Umgebungen.

Nutzen Sie robuste disk-Modelle (Enterprise‑HDDs/SSDs) und ähnliche Geräte in einem pool oder in mirrors für homogene Performance.

Kontrollieren Sie den Kernel mit uname -r und aktualisieren Sie das system vor der Installation, um Kompatibilitätsprobleme zu vermeiden.

Installation und Verifikation der Module

Installieren Sie das Paket mit sudo apt install zfsutils-linux oder sudo apt install zfs-dkms, je nach Kernel. Verifizieren Sie danach mit den Befehlen zfs –version, modinfo zfs und zpool version.

Prüfen Sie Geräte mit sudo lsblk und sudo lshw -class disk, legen Sie gegebenenfalls ein ARC‑Limit in /etc/modprobe.d/zfs.conf fest und führen update-initramfs durch.

Führen Sie abschließend einen Basistest (zpool list, zpool status) aus, um sicherzustellen, dass das Modul geladen und das storage‑system funktionsfähig ist.

Schnelleinführung: Pools und Datasets korrekt anlegen

Beim Anlegen eines Pools entscheidet das Layout maßgeblich über Redundanz und performance. Wählen Sie mirrors für einfache Redundanz oder raidz1/raidz2, wenn Parität und Platzbedarf im Vordergrund stehen.

Pool-Layouts, by-id und ashift für 4K-Sektoren

Nutzen Sie Geräte per /dev/disk/by-id, um Port- oder Kabelwechsel zu überstehen. Beispiel: sudo zpool create datapool mirror /dev/disk/by-id/…

Setzen Sie ashift=12 bei modernen 4K-disk Geräten, um Alignment-Probleme zu vermeiden und die I/O‑performance zu verbessern.

Datasets erstellen und Eigenschaften setzen

Erzeugen Sie logische Bereiche mit zfs create datapool/documents und steuern Sie space mit quota oder reservation.

Aktivieren Sie compression=lz4 standardmäßig. Feintuning erfolgt per recordsize, volblocksize, sync oder logbias je nach Workload.

Für SSD-Pools aktivieren Sie autotrim: zpool set autotrim=on datapool. Verwenden Sie bei Bedarf special vdevs, log und cache, um Latenzen zu reduzieren.

Prüfen Sie regelmäßig Status und Durchsatz mit zpool status und zpool iostat -v, um Engpässe früh zu erkennen.

ZFS Snapshots Ubuntu Server – Grundlagen und sichere Bedienung

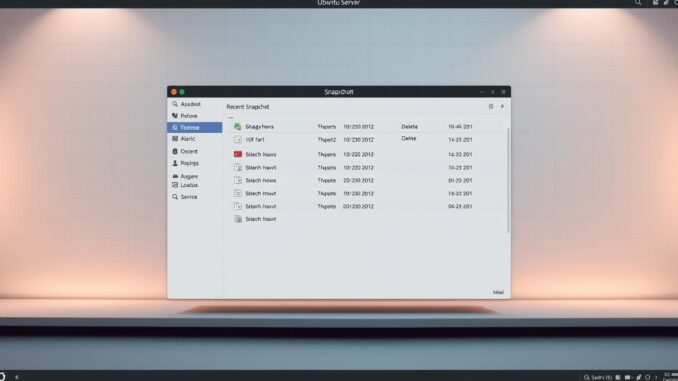

Eine klare Benennung erleichtert automatisierte Workflows und die schnelle Wiederherstellung eines bestimmten Zustands. Verwenden Sie stets das Format filesystem@snapshot; der Name nach dem @ hilft bei Retention und Suche.

Naming und Auflisten

Nutzen Sie filesystem@snapshot als Standard. So bleiben Namensraum und Übersicht konsistent.

Listen Sie vorhandene snapshots mit dem command zfs list -t snapshot, um Zeitpunkte und Abhängigkeiten schnell zu prüfen.

Erstellen, Umbenennen, Löschen

Manuell erzeugen Sie einen snapshot so: zfs snapshot rpool/example@snap1. Zum Umbenennen gilt: zfs rename rpool/example@snap1 rpool/example@snap2 — das filesystem muss gleich bleiben.

Zum Löschen nutzen Sie zfs destroy rpool/example@snap1. Entfernen Sie vorher abhängige Klone, sonst schlägt der destroy fehl.

Rollback auf einen Stand

Mit zfs rollback rpool/example@snap1 setzen Sie das aktive filesystem auf den Snapshot-Zeitpunkt zurück. Alle changes seit diesem snapshot gehen verloren.

Der Zusatz -r entfernt neuere snapshots automatisch; dokumentieren Sie diese Aktion gut, da sie Daten dauerhaft beeinflussen kann.

Snapshots automatisieren: Cron-Skripte und zfs-auto-snapshot

Mit einfachen Skripten und dem passenden Paket lassen sich Sicherungspunkte zuverlässig planen und verwalten.

Eigenes Cron-Skript: Zeitstempel, Retention und Beispiele

Ein kleines Script erzeugt snapshot-auto-$(date +%Y%m%d-%H%M) für ausgewählte Datasets. So bleibt der name sortierbar und die time sichtbar.

Das Beispiel behält die zehn neuesten Einträge und entfernt ältere per command zfs destroy. Tragen Sie das Script in crontab alle 6 Stunden ein, um ein sinnvolles Intervall zwischen Änderungen und Belastung zu schaffen.

Package zfs-auto-snapshot: Dataset-Properties für Frequenzen

Installieren Sie das Paket mit sudo apt install zfs-auto-snapshot. Aktivieren Sie pro Dataset die Property com.sun:auto-snapshot:frequent/hourly/daily/weekly/monthly via zfs set.

Die eingebaute Retention sorgt für konsistente Hierarchien und reduziert manuellen Aufwand im system.

Speicherplatz und Performance: Retention sinnvoll planen

Viele Sicherungspunkte erhöhen das space-Usage und können performance bei Auflistungen beeinträchtigen. Definieren Sie klare Regeln nach Business-Need und prüfen Sie Logs aus Cron, um Fehler und fehlgeschlagene backup-Läufe schnell zu erkennen.

Scrub-Zeitpläne einrichten und verstehen

Ein geplanter Prüfzyklus sichert die Konsistenz Ihrer pools und reduziert das Risiko stiller Datenkorruption.

Scrub vs. Snapshot: Datenprüfung und Selbstheilung

Ein Scrub liest alle data im gesamten pool, vergleicht 256-bit Checksummen und rekonstruiert fehlerhafte Blöcke aus redundanten Kopien.

Im Gegensatz dazu friert ein snapshot nur den state ein und dient der Wiederherstellung. Beide Mechanismen ergänzen sich, erfüllen aber unterschiedliche Aufgaben.

Automatisierung per cron/systemd: zpool scrub und Monitoring

Starten Sie manuell mit dem command zpool scrub <pool> und prüfen Sie Fortschritt und Ergebnisse mit zpool status.

Planen Sie zyklische Scrubs (z. B. monatlich) per cron oder systemd Timer. Führen Sie Prüfungen außerhalb von Spitzenzeiten aus, um die performance produktiver Workloads zu schonen.

Dokumentieren Sie Policies pro pool, verknüpfen Sie Events mit Monitoring/Alerting und führen Sie nach Hardwarewechseln einen außerplanmäßigen Scrub aus.

Mail-Benachrichtigungen für Scrubs, Fehler und Kapazität

Automatisierte Mails machen aus rohen Status‑Daten verwertbare Alerts für das Betriebsteam. Richten Sie ein send‑only MTA wie Postfix ein, um lokale Skripte zuverlässig Zustellung leisten zu lassen.

Testen Sie die Kette mit: echo „Test“ | mail -s „ZFS“ admin@example.com. So prüfen Sie, ob Mail, Parser und Empfänger korrekt arbeiten.

MTA-/Mail-Setup und Zustelltests

Installieren Sie Postfix als Minimal‑Relay und erlauben Sie lokale Deliveries. Führen Sie regelmäßige Zustelltests aus, damit der Pfad bis zum Empfänger funktioniert.

Status per Mail senden: zpool status, Fehler-Trigger und Hooks

Binden Sie den command zpool status in Wartungsskripte ein und parsen Sie die Ausgabe auf Schlüsselwörter wie DEGRADED, FAULTED oder ERROR. Bei Treffer löst das Skript eine Mail mit pool‑Name, Dauer und Resultat aus.

Nutzen Sie Cron, um Reports nach jedem Scrub oder bei Backup-Fenstern zu verschicken. Ergänzen Sie Hooks in Snapshot- und Scrub-Skripten, die Erfolg und Fehler melden.

Verwenden Sie sprechende Betreffzeilen wie [ZFS][pool]=HEALTHY|DEGRADED und archivieren Sie alle Mails im syslog zur späteren Analyse über längere time‑Spannen.

Remote-Backups mit zfs send/receive

Ein automatisierter Send-/Receive-Workflow reduziert Wiederherstellungszeiten und schützt wichtige Daten außerhalb des Standorts. Richten Sie eine klare Zielstruktur und Retention ein, bevor Sie erste Übertragungen starten.

Initiales Vollbackup

Erstellen Sie ein initiales Vollbackup mit einem rekursiven snapshot, zum Beispiel: zfs snapshot -r datapool@initial. Übertragen Sie den Stream direkt per SSH:

zfs send datapool@initial | ssh user@remote „zfs receive backuppool/datapool“

Stellen Sie sicher, dass das Zielpool existiert und genug Platz hat. Notieren Sie die Snapshot‑name im Log.

Inkrementelle Backups und Rolling-Snapshots

Nutzen Sie inkrementelle Streams (-i), um nur die changes zwischen zwei snapshot-Zeitpunkten zu senden. Beispiel:

zfs send -i datapool@initial datapool@backup-YYYYMMDD | ssh user@remote „zfs receive backuppool/datapool“

Automatisieren Sie rolling-snapshots (z. B. daily backup-YYYYMMDD) per Cron. Ein Script erkennt den letzten snapshot, wählt Full oder Incremental und hält nur die letzten fünf Sicherungen.

Verschlüsselte Offsite-Backups und Restore

Für verschlüsselte Offsite-Backups pipe den Stream in GPG:

zfs send … | gpg –symmetric –cipher-algo AES256 > datapool-YYYYMMDD.zfs.gpg

Zum Wiederherstellen: gpg –decrypt datapool.zfs.gpg | zfs receive restorepool/datapool

Testen Sie regelmäßig Test‑Restores und dokumentieren Sie Logs, damit Backups im Ernstfall verlässlich wiederherstellbar sind.

Performance und Ressourcenbedarf im Blick behalten

Gute Performance entsteht durch kontinuierliches Monitoring und gezieltes Tuning der Cache- und SSD‑Ressourcen.

ARC-Überwachung und Limits setzen

Überwachen Sie ARC mit cat /proc/spl/kstat/zfs/arcstats, um Cache-Größen, Trefferquoten und mögliche Engpässe früh zu erkennen.

Setzen Sie ein bytes-basiertes Limit mit echo „options zfs zfs_arc_max=4294967296“ > /etc/modprobe.d/zfs.conf, führen Sie update-initramfs -u aus und starten Sie neu.

SSD-Tuning: autotrim, Special VDEV, SLOG und L2ARC

Aktivieren Sie autotrim auf SSD-Pools: zpool set autotrim=on. Das stabilisiert Schreiblatenzen im Zeitverlauf.

Nutzen Sie SLOG für viele synchrone Writes und Special VDEV für Metadaten-lastige Workloads. L2ARC verbessert Lesecache, erhöht aber Schreibverschleiß auf der SSD.

Feinjustierung, Monitoring und Praxisregeln

Passen Sie recordsize, primarycache und logbias an den Workload an und messen Effekte mit zpool iostat -v sowie Latenzmetriken in definierten time‑Fenstern.

Behalten Sie space im Blick: Pools über ~80% fangen an, deutlich an performance zu verlieren. Dokumentieren Sie alle Tuning‑Schritte, um Änderungen bei Bedarf zurückzunehmen.

Best Practices, Warnungen und Recovery-Strategien

Praktische Vorgaben für Alltag und Notfall sichern Integrität und Verfügbarkeit Ihrer Pools.

Aktivieren Sie standardmäßig Kompression (LZ4) und legen Sie ashift=12 beim Erstellen fest. Nutzen Sie /dev/disk/by-id für stabile Device‑Namen und setzen Sie Quotas, um space pro Dataset zu begrenzen.

Halten Sie einen pool unter 80% Belegung. Hohe Füllstände verschlechtern die Performance und erhöhen Fehleranfälligkeit.

Verwenden Sie inkrementelle Sends (zfs send -i) für effiziente Offsite‑Transfers. Snapshots sind nützlich, aber kein Ersatz für externe Backups.

Vorsicht bei zfs destroy: solche Operationen können viel I/O binden. Planen Sie Wartungsfenster und nutzen Sie async-destroy, wenn verfügbar.

Vermeiden Sie Deduplizierung ohne klaren Bedarf — sie braucht viel RAM und lässt sich schwer rückgängig machen. Bauen Sie keine Pools auf Dateien anderer pools.

Erstellen Sie regelmäßig Konfig‑Dumps: zpool status -v > /root/zfs_pool_config.txt und zfs list -o all > /root/zfs_dataset_config.txt. Lagern Sie diese Dateien außerhalb des betroffenen systems.

Für Recovery: exportieren vor dem Transport, importieren am Ziel mit zpool import -d /dev/disk/by-id. Bei Problemen hilft zpool import -f. Setzen Sie früh ARC‑Limits, um OOM‑Risiken zu reduzieren.

Nächste Schritte: Von den ersten Snapshots zum belastbaren Backup- und Scrub-Betrieb

Ein strukturierter Fahrplan hilft, aus Einzelmaßnahmen einen belastbaren Backup- und Prüfprozess zu formen. Starten Sie mit einem klaren name‑Schema (Datum+Uhrzeit) und aktivieren Sie automatische snapshots pro Dataset für reproduzierbare Wiederherstellungspunkte.

Planen Sie regelmäßige Scrubs in festen time‑Fenstern (z. B. monatlich) und prüfen Sie nach jedem Lauf den state des pool per status‑Report. Verknüpfen Sie diese Reports mit Mail‑Alerts, damit Fehler sofort sichtbar werden.

Etablieren Sie inkrementelle backup‑Jobs mit send/receive (-i) und automatisierter Retention. Führen Sie regelmäßige Restore‑Tests durch, dokumentieren Runbooks für Rollbacks und schulen one On‑Call auf Risiken wie destroy oder rollback.

Setzen Sie ARC‑Grenzen, aktivieren Sie autotrim und überwachen performance‑Metriken. Pflegen Sie Konfig‑Dumps extern und evaluieren Sie die Strategie quartalsweise, um wachsende data‑Anforderungen anzupassen.